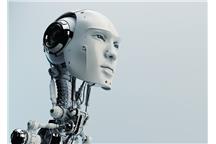

Grupa naukowców z Tufts University, Brown University oraz Rensselaer Polytechnic Institute współpracują z US Navy w wieloletnim projekcie, którego celem jest zbadanie, w jaki sposób można stworzyć roboty obdarzone własnym poczuciem moralności . Jeśli im się to uda, sztuczna inteligencja będzie zdolna do autonomicznej oceny trudnych sytuacji, a następnie będzie w stanie dokonywać skomplikowanych decyzji etycznych, mając wpływ na zmianę sztywno narzuconych jej instrukcji.

Siedemdziesiąt dwa lata temu pisarz science fiction, Isaac Asimov wprowadził „trzy prawa robotyki", które mogłyby być moralnym kompasem dla wysoce zaawansowanej sztucznej inteligencji. Niestety, biorąc pod uwagę , że obecnie najbardziej skomplikowane algorytmy są nadal dość kruche, a roboty nie zdają sobie sprawy z otaczającego ich świata w ścisłym znaczeniu tego słowa, naukowcy mają dość wiele do zrobienia.

Zespół naukowców kierowany przez profesora Matthiasa Scheutza z Tufts University chce rozwiązać ten trudny problem, starając się rozbić ludzki kodeks moralny na podstawowe cegiełki, opracowując ramy dla ludzkiego rozumowania w zgodzie z prawami etyki. Następnie badacze spróbują opracować modelowy algorytm, który zostanie osadzony w sztucznej inteligencji. Założenia pozwolą robotowi zmienić nadane mu instrukcje w obliczu nowych sytuacji oraz uzasadnić swoje wybory ludziom, którzy go będą kontrolować.

Przykładem jest sytuacja, w której robot medyczny, któremu kazano pilnie przetransportować leki do pobliskiego szpitala, spotyka na swojej drodze osoby w stanie krytycznym. Prawidłowo skonstruowany „moralny kompas" pozwoli mu na ocenę sytuacji i podjęcie autonomicznej decyzji, czy misję należy przerwać, czy kontynuować z uwzględnieniem wcześniejszych założeń.

Jeśli powieści Asimova nauczyły nas czegokolwiek, to tego, że moralność nie jest sztywnym, zaprogramowanym zestawem reguł i trzeba się liczyć z wszelkimi, nawet nieprzewidywalnymi scenariuszami. Scheutz i jego koledzy zgadzają się w tej kwestii i opracowali dwuetapową próbę rozwiązania tego problemu.

W ich wizji, wszystkie decyzje robota muszą zostać najpierw poddane wstępnej kontroli etycznej przy zastosowaniu zaawansowanych technik AI, chociażby użytych przy opracowaniu robota IBM, Watsona Jeśli potrzebna będzie dodatkowa pomoc, robot będzie opierał się na systemie, który naukowcy opracują jako algorytmiczny model ludzkiej moralności.

Ponieważ projekt jest realizowany we współpracy z US Navy, technologia może znaleźć swoje pierwsze zastosowanie w opracowaniu robotów medycznych przeznaczonych do pomocy żołnierzom na polach bitwy.

(rr)

Kategoria wiadomości:

Nowinki techniczne

- Źródło:

- gizmag

Komentarze (0)

Czytaj także

-

Od 6 do 17 cobotów w trzy lata. Automatyzacja się opłaca

Lipton Teas and Infusions podniósł wydajność paletyzacji w katowickim zakładzie dzięki wdrożeniu cobotów Universal Robots na końcówkach linii...

-

Kluczowa rola wycinarek laserowych w obróbce metali

Wycinarki laserowe zrewolucjonizowały przemysł obróbki metali, oferując niezwykłą precyzję i efektywność. Dowiedz się, dlaczego są one...

-

-

-

-

-

-